🔗 PDF Link 🍺 Github Code ECCV2020上一篇关于可解释性的文章,记录一下。文章主要目标就是为了去解决为什么人脸识别可以精准的判断测试图像是谁,为什么不会匹配到另一个人脸上去。

Section 1 介绍

目前来说,在大量数据集上训练的深度卷积网络模型一直被认为是一个黑匣子,模型设计者通常来说会对数据集和损失函数做出一些理解,从而提出一些改进,但是很少会对训练出的模型的有一定的理解解释。此外,为什么特定的输入就会有这样的结果对应也是不明确的。明确这样的关系可以让人更人性化的模型可视化,进一步的可以构建一些让人信服的解决方案,应用于更广泛的应用场景。

专业的面部识别分析遵从FISWG标准,主要是比较面部形态,测量面部关键点并匹配疤痕,痕迹和瑕疵。这些特征用于比对一个controlled mugshot(人脸库里的图像)和一个uncontrolled probe(比如摄像头拍下的图)。但是,按照这个方法来进行判断的话会存在一个问题,就是人力是有限的,需要人脸匹配系统提供一个候选列表。那问题就来了,为什么匹配系统会根据这个uncontrolled probe产出这个列表呢?人脸匹配系统是否也遵从了FISWG标准呢?它是否有偏好和噪声?XFR主要目的就是为了解决这个问题。

什么才叫可解释的人脸识别呢?可解释AI[1]实际上 提出了一些方案,例如激活最大化,合成最佳图像,网络注意力,网络解剖或者是生成语言解释等。但是,本质上最关键的挑战在于没有Ground Truth来对比和量化。XFR尤其具有挑战性,因为near-mates或doppelgangers之间的差异很小,解释也不明显,并且差异很少会恰好地坐落在紧凑的面部特征中。

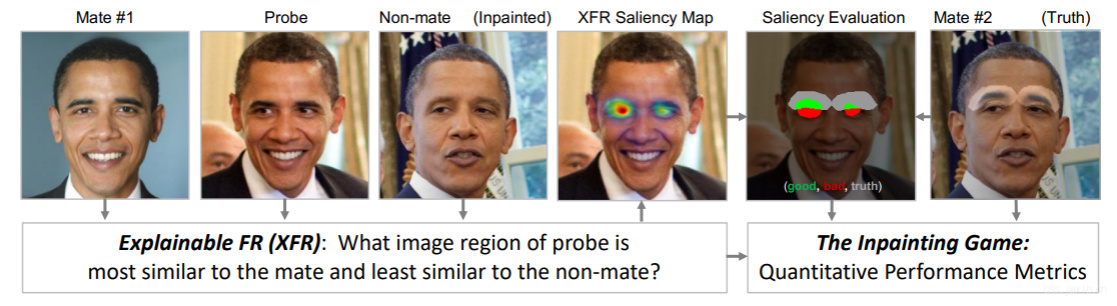

本文首先提供了一个可解释的人脸识别基准,图1展示了问题的结构。

一个XFR的问题实际上涉及了三种图像数据probe,mate和nonmate,XFR的任务就是去生成一张显著性图来展示probe和mate哪里是一样的,和nonmate哪里是不一样。这样就能够解释为什么(probe,mate)这个pair能取得较高的验证分数,而(probe。nonmate)的分数则较低。因此,这也提供了一个量化的策略来进行评估可解释性。

一个XFR的问题实际上涉及了三种图像数据probe,mate和nonmate,XFR的任务就是去生成一张显著性图来展示probe和mate哪里是一样的,和nonmate哪里是不一样。这样就能够解释为什么(probe,mate)这个pair能取得较高的验证分数,而(probe。nonmate)的分数则较低。因此,这也提供了一个量化的策略来进行评估可解释性。

贡献:

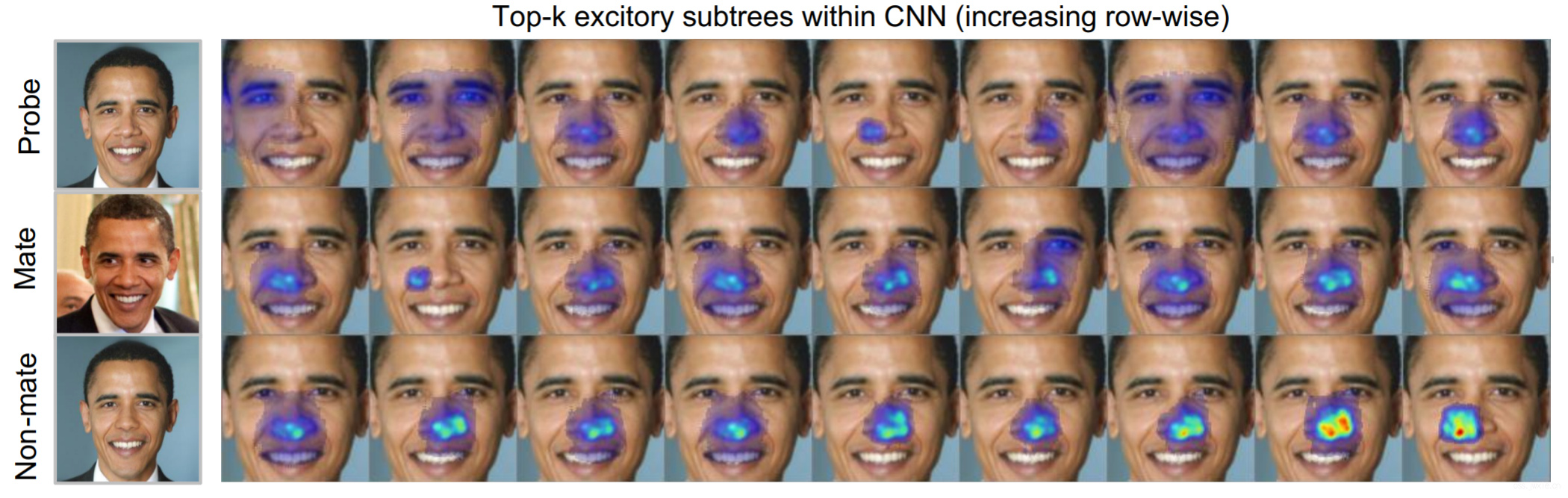

- XFR baseline,在三种公开的卷积网络:LightCNN,VGGFace2和ResNet-101上提供了五种网络注意力机制的XFR baseline。这些baselines里面还包括了两个新的关于注意力机制的算法subtree EBP。

- 评估指标以及数据集。提出另一个标准的评估指标和数据集,用于细粒度的人脸面部判别分析可视化。

- XFR evaluation,提出了一个benchmark。

Section 2 相关工作

Section 3 方法

Reference

[1]W. Samek, G. Montavon, A. Vedaldi, L. K. Hansen, and K. M¨uller, editors. Explainable AI: Interpreting, Explaining and Visualizing Deep Learning. Springer, 2019. 1